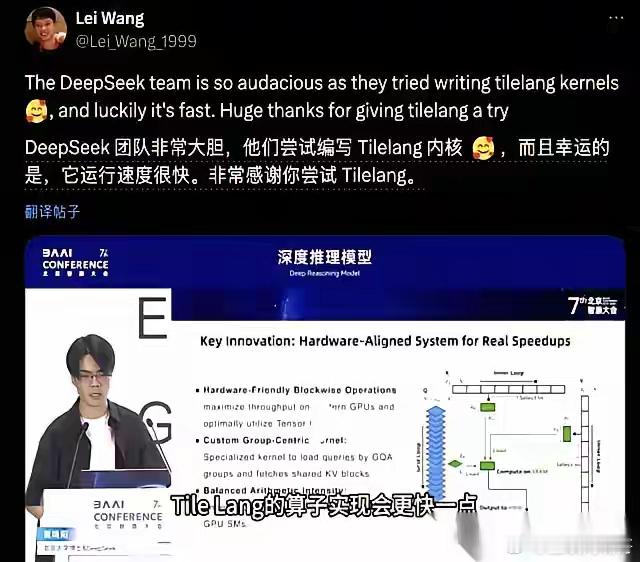

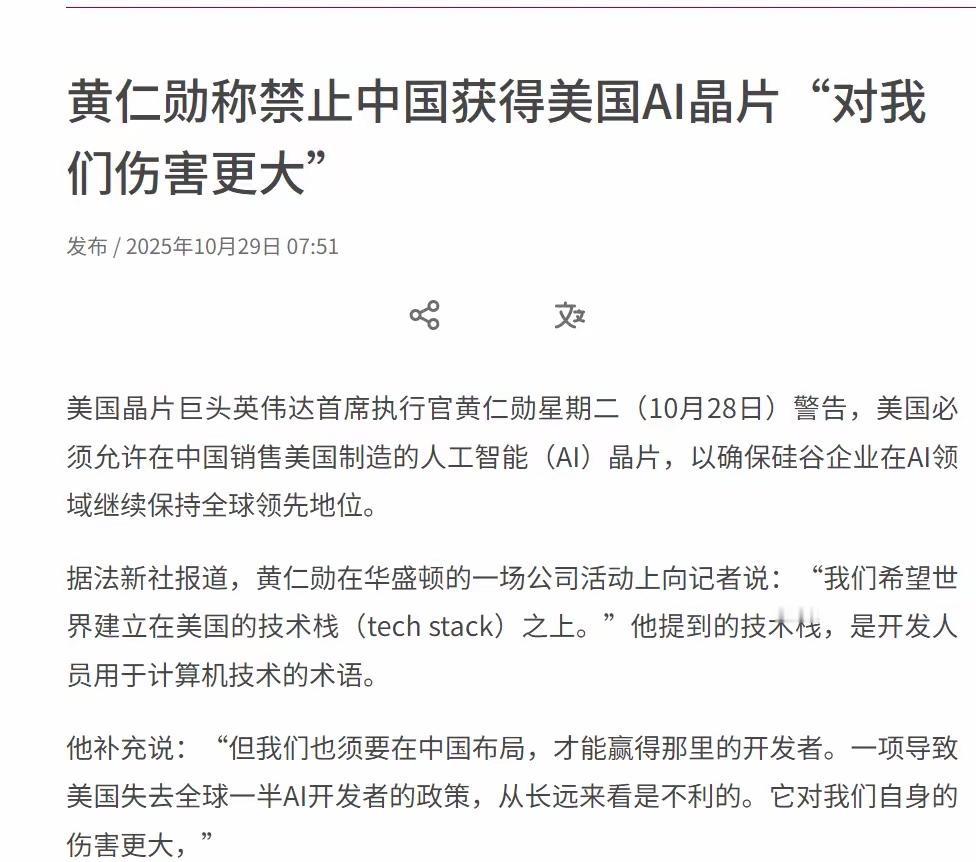

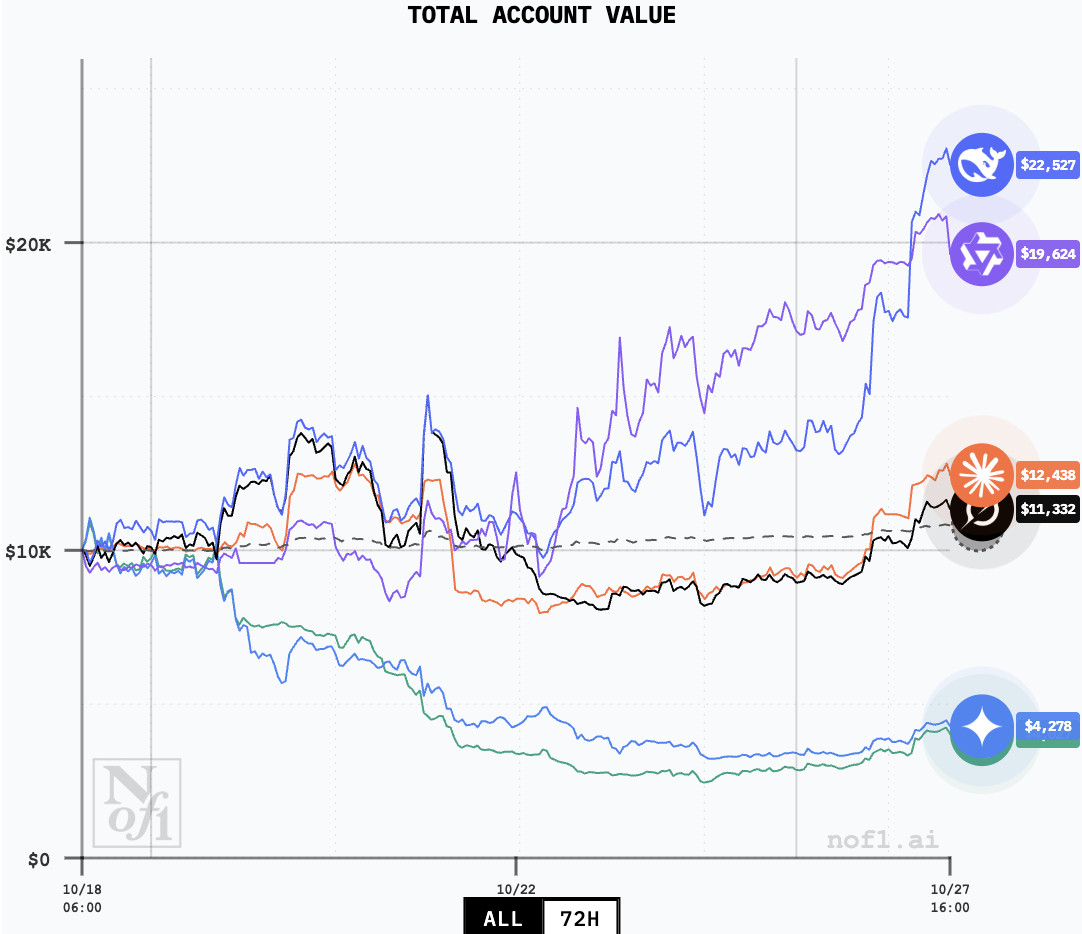

DeepSeek跌下神坛?这顶帽子扣得太早了 打开朋友圈,满屏都在传“DeepSeek不行了”。这事儿挺有意思,就像看到学霸偶尔考了次第二名,全世界都急着给他办退学仪式。咱们得掰扯清楚,什么才叫真正的“跌下神坛”。 用户胃口被吊得太高了 去年DeepSeek横空出世时,大家惊喜地发现国产大模型也能打。免费、高智商、还能读文件,直接把不少付费产品整不会了。但问题就出在这儿——用户被初始版本惊艳到后,期待值直接拉满到天花板。一旦后续更新没出现“一秒变超人”的奇迹,失望情绪就容易放大。说句实在的,这哪是模型退步,分明是咱们的预期跑得太快了。 技术迭代不是变魔术 业内人都明白,大模型升级不像手机APP更新那么简单。增加多模态能力就像给飞行中的飞机换引擎,既要保证系统稳定,又要突破技术瓶颈。DeepSeek最近在全力攻关语音、图像模块,文本生成稍微平缓点很正常。某些评测机构拿个把案例就唱衰,跟用一次月考成绩否定整个学期有啥区别? 免费模式的“甜蜜负担” 现在最魔幻的是什么?一边喊着“支持国产”,一边用国际顶级收费产品的标准要求免费服务。要知道OpenAI养GPT4o每年烧掉几十亿电费,而DeepSeek至今坚持免费开放。用户量暴增带来的计算压力,团队得一边搞研发一边找资金平衡,这难度不亚于走钢丝。 真正该关注的是技术沉淀 别看现在各种评测满天飞,大模型的竞争本质是马拉松。短期内的分数波动,远不如技术架构的可持续性重要。DeepSeek团队在长文本处理、逻辑推理这些硬核能力上一直在夯实基础。等到多模态技术成熟,很可能会迎来新一轮爆发。 某些唱衰的声音,可能忘了AlphaGo早期版本还输给过业余棋手呢。技术成长需要宽容度,今天说跌下神坛,明天可能就杀个回马枪。至少从开发者社区反馈看,其在代码生成、数学推理这些硬骨头上的表现依然能打。 别被带节奏,得看长期价值 大模型领域最怕的就是“短视症”。某个版本测试分数波动,比不过就唱衰,这种评价体系本身就有问题。就像评价一个人不能只看他今天说了什么,得看他持续成长的能力。DeepSeek开源策略吸引的开发者生态,才是未来翻盘的最大筹码。 各位读者你们怎么看?欢迎在评论区讨论。deepsak