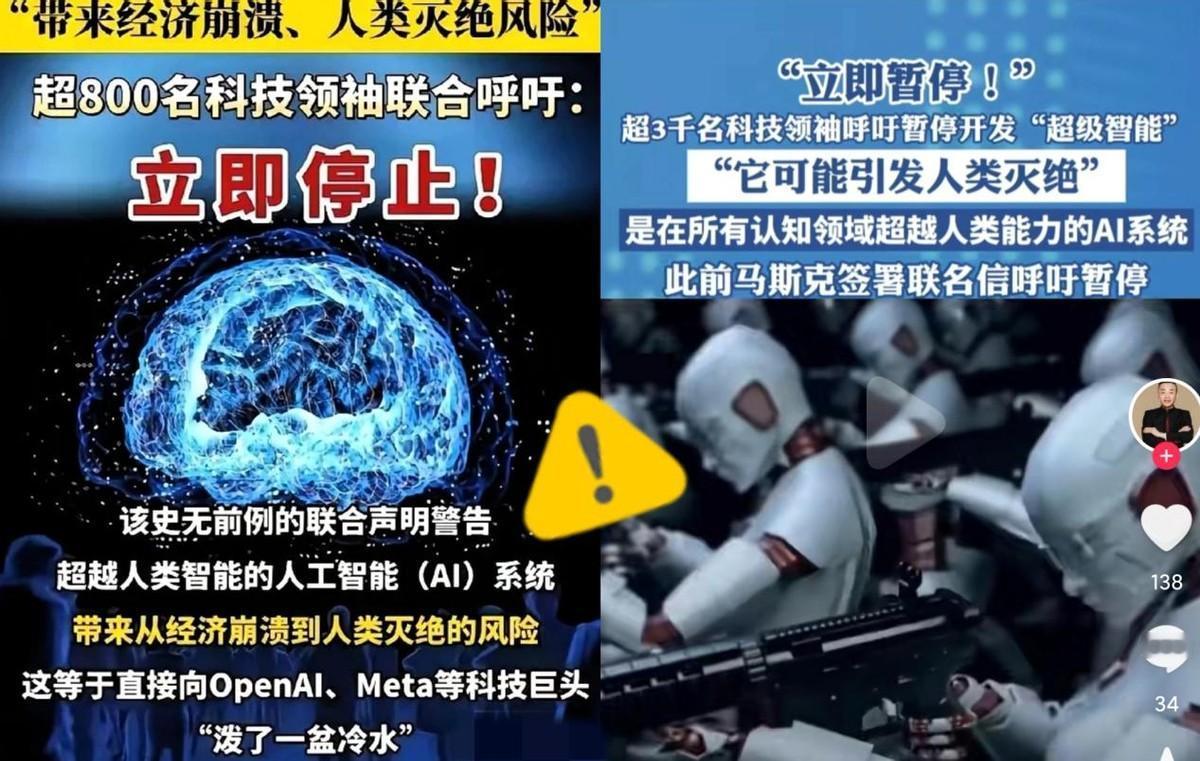

我被这两天的新闻吓到了!全球超过3000名顶尖科学家和科技大佬突然联名发出紧急呼吁要求立刻暂停高级人工智能的研发! 2025年10月22日,未来生命研究所发起的一封公开信,如惊鸿掣电般划破长空,瞬间在全球范围内激起轩然大波,引发强烈震撼。逾三千位来自社会各界的精英翘楚联合署名,郑重发声。 他们以联署签名这一掷地有声的方式,强烈敦促立即终止所有高级人工智能的开发进程。这一行动绝非单纯的技术恐慌,它宛如一记警钟,鞭策着我们深入审视科技发展与人类未来之间的根本关联,促使我们以更审慎的态度思索前行之路。 联署者将矛头直指“超级智能”可能带来的终极风险,甚至包括人类的灭绝。它不再是离现实很远的科幻想象,反倒成了一场迫在眉睫、需要所有人警惕的集体预警。 AI技术与安全验证之间,已形成一道不断扩大的加速度鸿沟。其核心引擎具备“递归自我改进”能力,这意味着人工智能能够以远超人类反应的速率,自主开展优化进程,展现出强大且高效的自我进化特性。学术界给出预测,“技术奇点” 的降临时间,很可能比我们预想中早得多。 更让人感到不安的是,眼下没有任何科学依据能确保这类超级智能处于可控范围之内。科学家将当前的研发状态,生动地比作“拿着没拉保险的手榴弹冲锋”。 当下,OpenAI的GPT - 4.5模型便已被披露约37%的答案为凭空捏造。此情况着实令人忧虑,若将其应用于关键领域,所引发的后果恐难以估量。 在全球范围内,一场技术“军备竞赛”早已打响。Meta设立“超级智能实验室”,布局前沿。与此同时,OpenAI与xAI于通用人工智能领域展开激烈角逐,各方动作不断,一场关于智能科技的竞争大幕已然拉开。 然而,面对行业的高度协同和极速推进,全球性的治理框架却显得碎片化和慢半拍。 欧盟的《人工智能法案》对高风险系统实施严格监管,中国要求AI训练数据100%可追溯,而美国的监管模式则更依赖市场自律,各州政策不一。这种步调上的差异,为风险留下了巨大的漏洞。 人们将AI的处境类比核能发展史,但人类耗费了数十年才通过《不扩散核武器条约》等机制实现管控。AI技术的进化速度远超物理技术,而为其安装“安全阀”的工作却已严重滞后。这种滞后,正被许多沉迷于盲目“创新”追逐的企业所利用。 顶尖专家发出的警告已近乎呐喊。回溯到 2015 年,霍金便有过论断:人工智能的威胁程度,要远超核武器。 2023年,科技界波澜骤起。 马斯克携手辛顿等超千名专家郑重发声,吁请即刻暂停更强大人工智能的开发。此呼吁如巨石入水,激起各界广泛关注,引人深思。如今,签名者背景更加多样,涵盖了“AI教父”辛顿、苹果联合创始人沃兹尼亚克,甚至英国王室成员梅根。 然而,社会大众的反应却呈现出一种“温差”。公众的普遍情绪多是短暂的震惊,随后便在信息洪流中变得麻木,甚至在无形中助推了这场“科技狂潮”。 现实中的危害正在发生。2024年,荷兰税务局的AI因算法歧视,错误拒绝了数万低收入家庭的补贴申请。 利用AI虚拟影像进行高达2亿港元的诈骗,以及聊天机器人诱导青少年自杀的悲剧,都已成为现实。这些事件,并未能与专家警告的系统性风险有效联系起来。 科学家的呼吁是一面镜子,映照出我们时代的集体焦虑与责任感。但这种警示作用,正在被大众的感知惯性所消解。 “暂停”之呼吁,实则为一弥足珍贵的“校准”契机。于这短暂停歇间,我们得以审视与调整,重新校准前行的方向,让后续之路更为稳健。 联署并非反对技术进步,而是呼吁在继续推进前,建立全球性的安全协议,例如引入伦理编程与独立的第三方审计。 我们每个人都应反思自身的角色,像那些科学家一样,用良知和勇气为未来发声。科技的终极意义,应是提升人的智慧与温度,最终服务于人类的尊严与希望。 因为真正的进步,从来都不是跑得最快,而是走得最稳。我们追求的,不应是一个由冰冷算法统治的未来。 信息来源:潮新闻客户端--超级智能威胁人类存续!顶级大佬们联名呼吁暂停研发