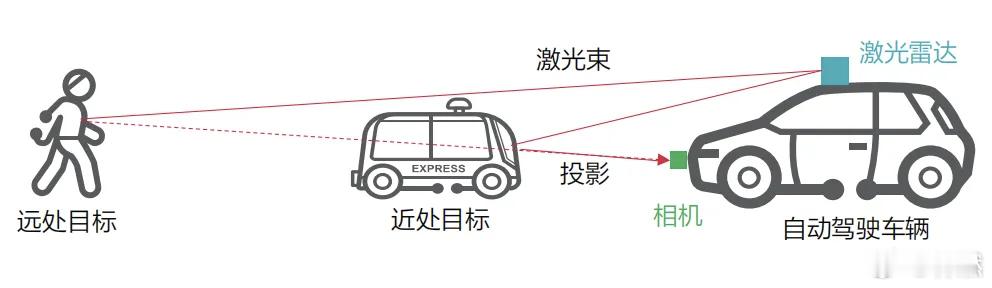

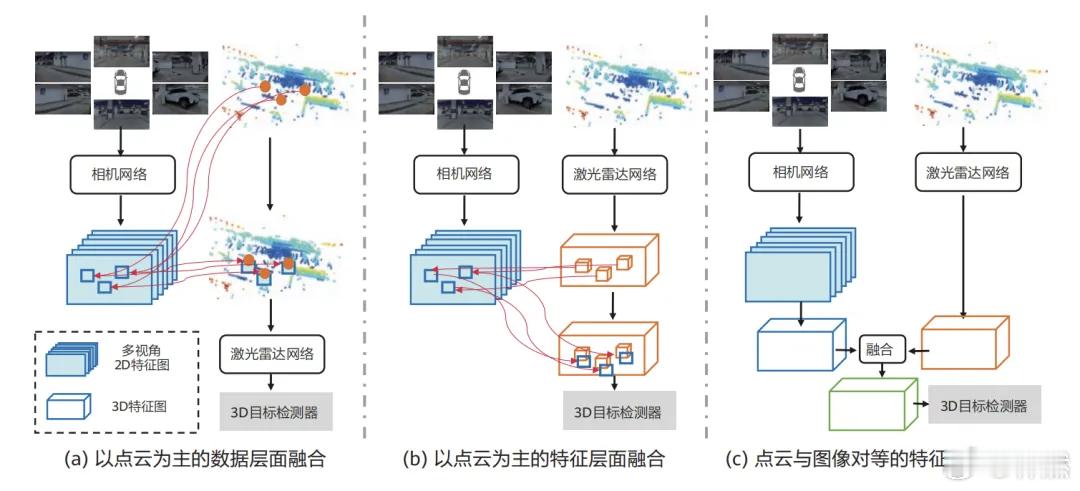

从当前硬件系统的实现和学术界的研究工作来看,如何有效地融合摄像头、激光雷达、毫米波雷达这些多模态传感器的数据并非易事。首先也是最重要的,如果摄像头和激光雷达安装在不同的位置上,由高度、角度不一带来的视角差异会导致不同传感器观测到的环境目标可能不同。比如激光雷达安装在车顶位置而相机安装在保险杠位置(或者相反),当前方有障碍物时,由于相机和激光雷达存在高度的差异,两者观测到的环境目标可能是不同的,如果单纯利用相机和激光雷达的外参进行投影融合,就会产生因遮挡导致探测的目标不一致的问题。这个难题或许正是小鹏汽车抛弃激光雷达、转向纯视觉方案的重要原因之一。其它几乎所有车企都选择将激光雷达安装在车顶上,与前视摄像头相近的位置,大大缓解了因安装位置不一致导致的空间对齐问题。但是,小鹏汽车把两颗角毫米波雷达安装在前保险杠两侧,和前视摄像头的视野存在相当大的不同。这时,它必然遭遇因安装位置不同导致环境目标感知不同这种很难克服的难题。除了安装位置导致的横看成岭侧成峰、远近高低各不同,不同传感器在时空相位、数据帧率、信息尺度上也会存在差异。激光雷达的帧率在10-20Hz之间,摄像头的帧率在30-60Hz之间,激光雷达和摄像头这两个传感器的数据在时间维度上天然就是非对齐的,这种效应在汽车快速运动下表现得尤其明显。因此,简单地利用内外参将点云投影到图像平面,会导致点云和像素无法对齐的情况在硬件层面,可以为所有传感器都提供统一的时间基准,再通过精确时间协议或传感器硬件触发接口直接控制传感器在相同的时刻进行采集。在软件层面,可以通过时间戳对齐与数据插值,为不同时间戳的数据建立关联,并通过算法估计或预测同一时刻的数据状态。如果不采用前融合,可以将不同传感器提取的特征映射到统一的空间后,再在BEV或OCC空间内进行融合。至于其它难题,兵来将挡,水来土掩,总归是有办法解决的。大v聊车