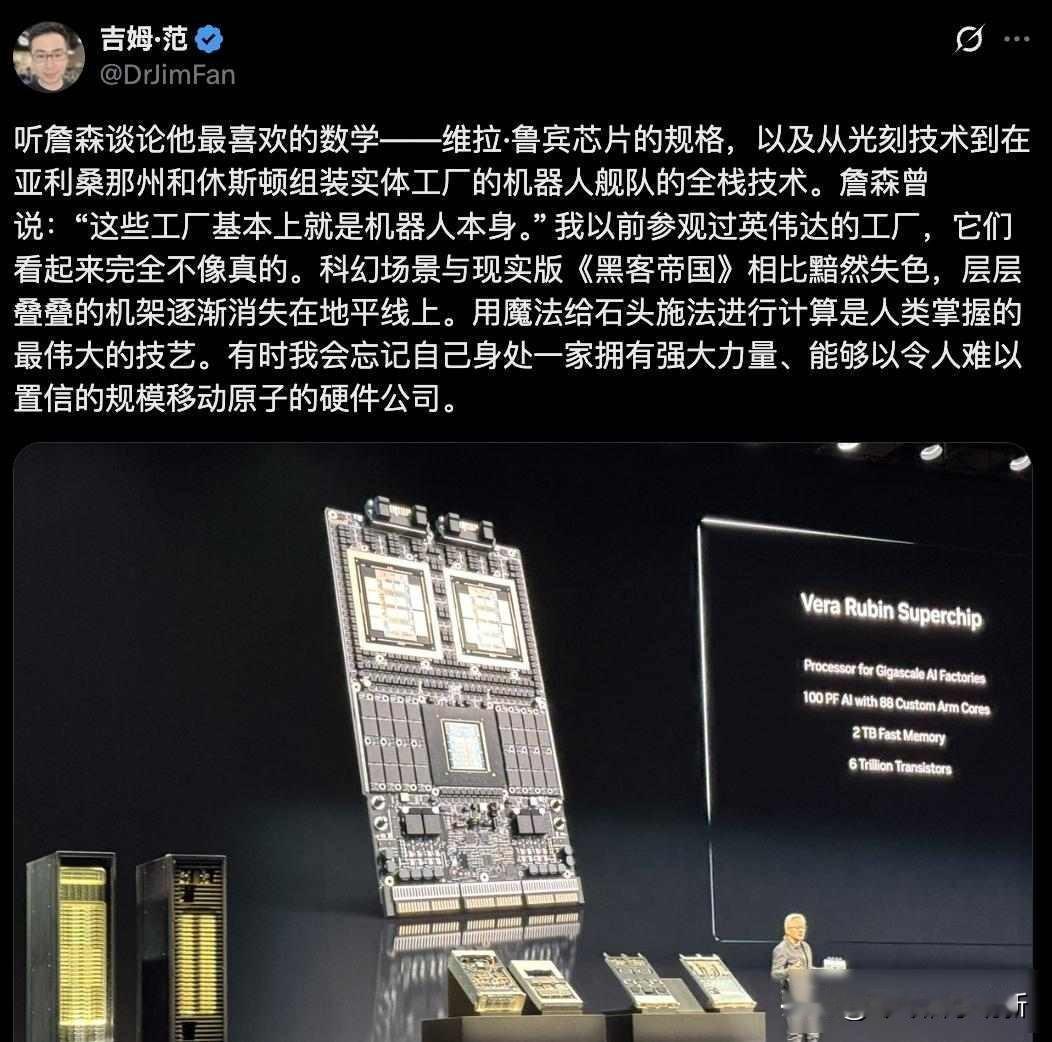

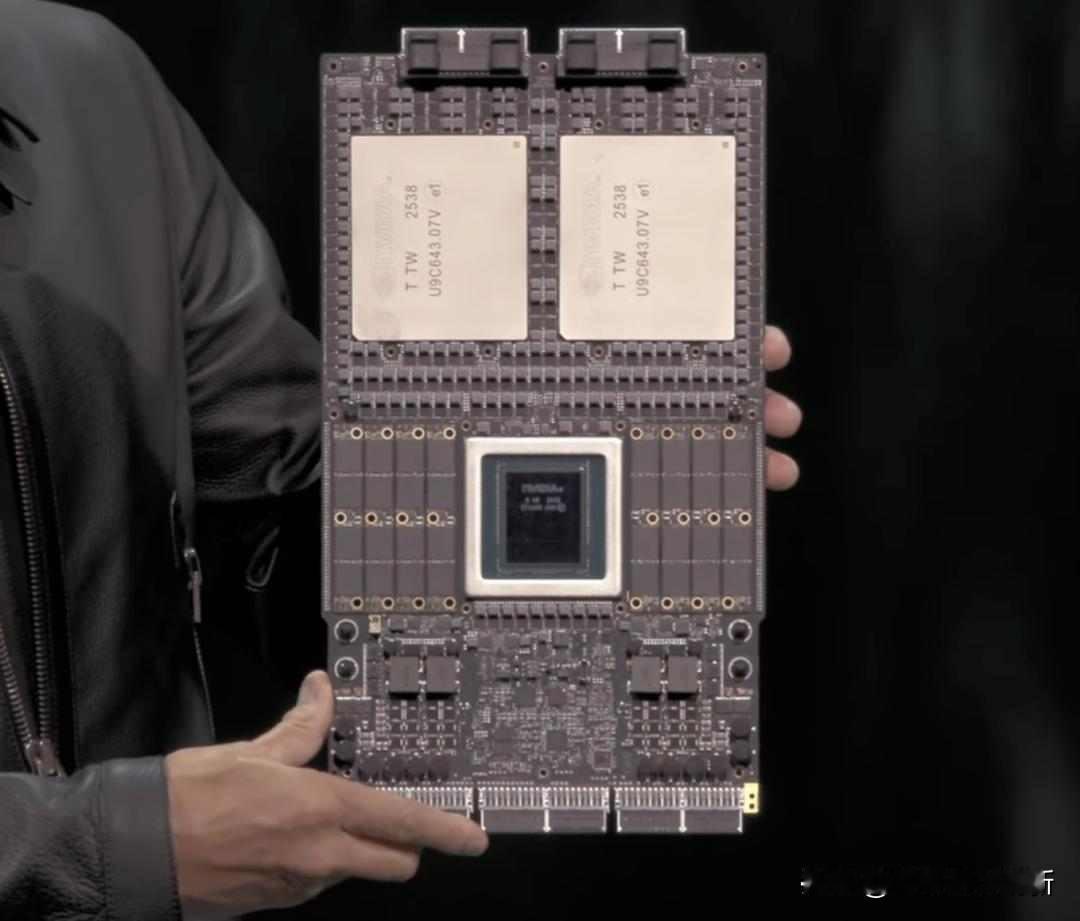

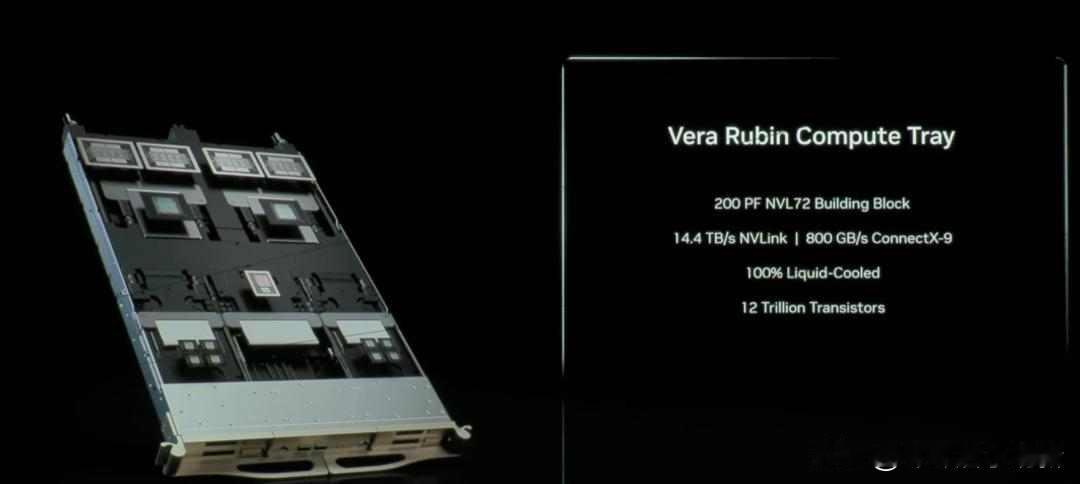

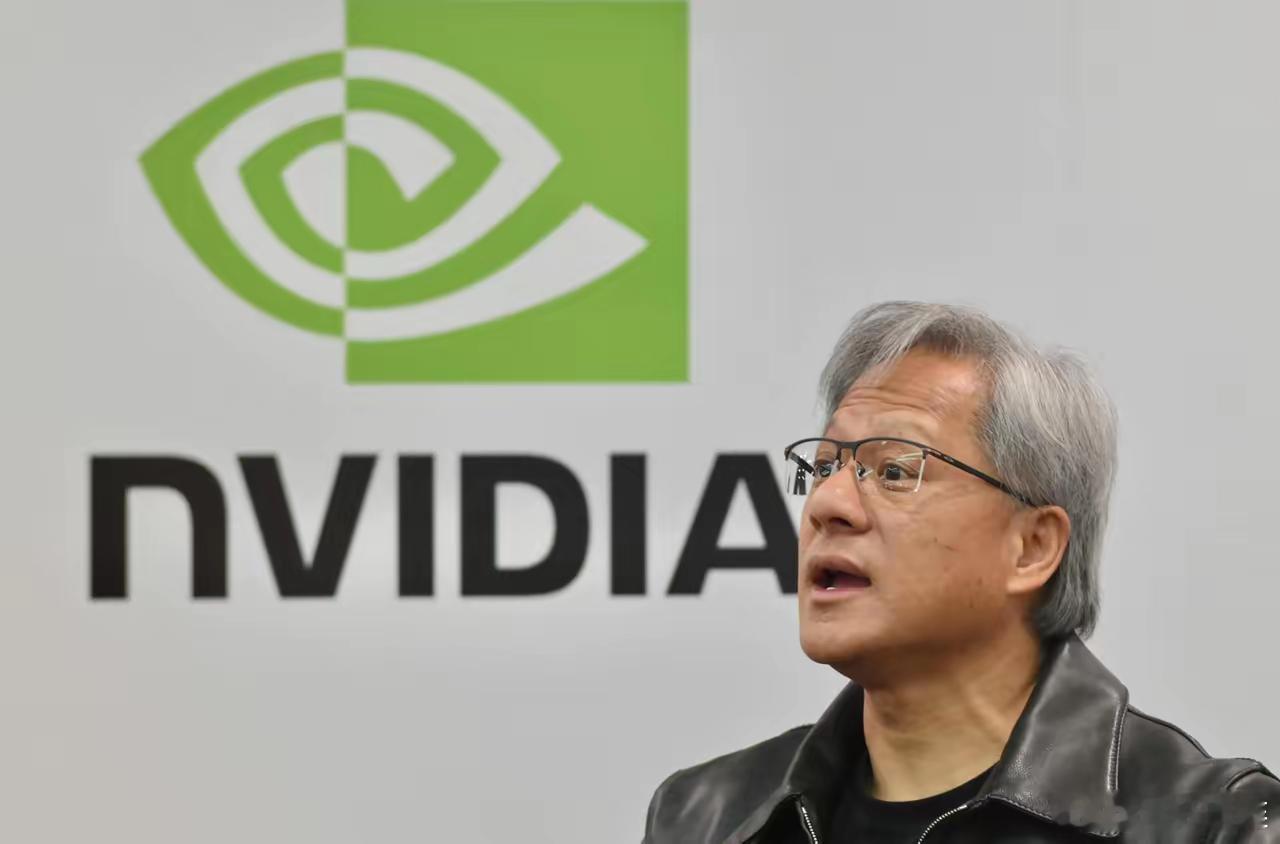

黄仁勋点赞中国模型,算力战场却悄悄换人,谁在背后推着芯片跑? 2024年GTC大会上,英伟达的黄仁勋推出了新芯片Vera Rubin,这芯片用两个GPU加一个CPU,算力直接拉到50PFLOPs,内存用的是HBM4,散热搞了无线液冷,他说2026年下半年NVL144平台就能量产,推理算力做到3.6Exaflops,2027年升级版NVL576能到15Exaflops,比之前的GB300强了14倍,他还和HPE合作,给洛斯阿拉莫斯实验室建两台超算,预计2027年上线,更狠的是,他把2028年的Feynman芯片也安排上了,订单已经堆到5000亿美元。 黄仁勋最近讲话,一半时间都在讲中国AI模型,他点名提到Qwen和DeepSeek,说它们是真厉害,不是随便说说的,中国团队没跟着欧美比谁参数大,而是琢磨怎么用更少的算力训出好用的模型,他们搞稀疏架构,做轻量推理,结果模型跑得更快,还更省电,这条路正好跟英伟达的高密度算力路子搭得上,中国不是买一堆GPU堆模型,而是用模型反过来告诉芯片该怎么改,逼着硬件厂调整设计。 英伟达不光盯着GPU,还往量子和6G里头钻,搞了个NVQLink加CUDA-Q,让量子处理器和GPU能互相传数据,一块儿做混合模拟,又砸了十亿美金投诺基亚,搞Aerial RAN Computer,用Grace加Blackwell加ConnectX搭AI原生的6G基站,想把通信设备变成AI处理器,但别以为就他们动,IBM用FPGA加算法绕开GPU做量子计算,速度翻了十倍,AMD靠Instinct MI355X拿下了十亿美金的超算单子,单板功耗一千四百瓦,装机速度最快,高通也憋着大招,AI200和AI250芯片瞄准低运维成本的市场,2026年开始杀进数据中心。 很多人光盯着英伟达,其实别的公司早就在悄悄干,台积电虽然代工Rubin GPU,但中国公司已经在搞HBM4封装、液冷、CPO光模块这些事,华为昇腾、寒武纪、黑芝麻智能都在做FP4和FP8的低精度推理芯片,阿里达摩院、字节云智也在搭模型、芯片、算力一起上的一条线,黄仁勋说中国芯片要爆发,这话听着像夸你,其实是提醒你,当中国团队开始用模型反过来定硬件怎么设计,全球AI基础设施的主控权就在换人了,没人再等别人给方案,大家都自己动手,按自己的步子走。 算力这事儿,以前看谁家芯片多,谁家服务器贵,现在不一样了,模型怎么跑,硬件就得怎么改,算法一变,架构就得跟着调,连散热和内存都得重新配,英伟达还在往前跑,后面追的人越来越多,有人拿量子绕道,有人靠6G抢位置,还有人从材料底子开始改,黄仁勋嘴上夸中国模型,心里门儿清,这场仗,早不是一个人能打下来的。