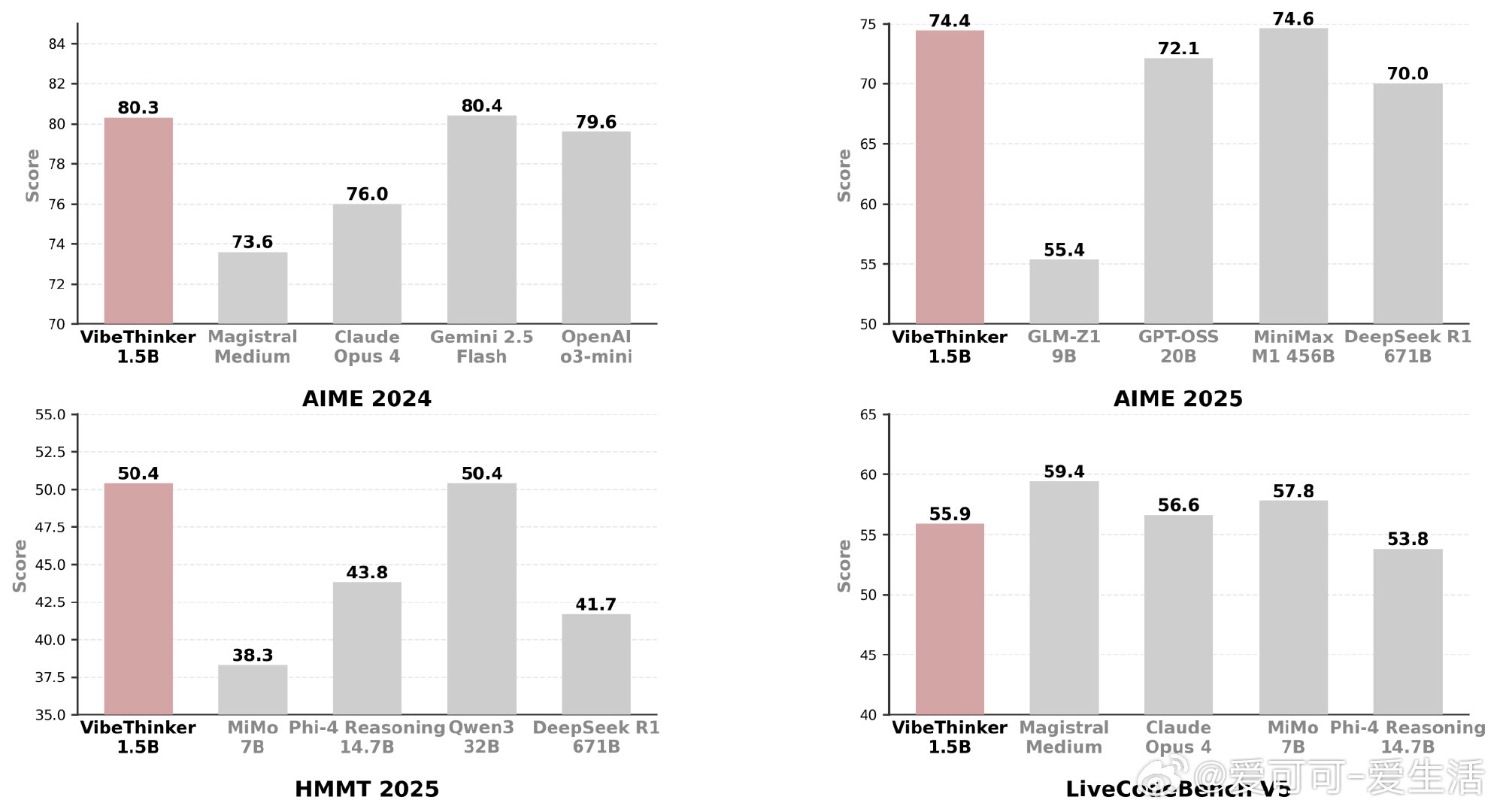

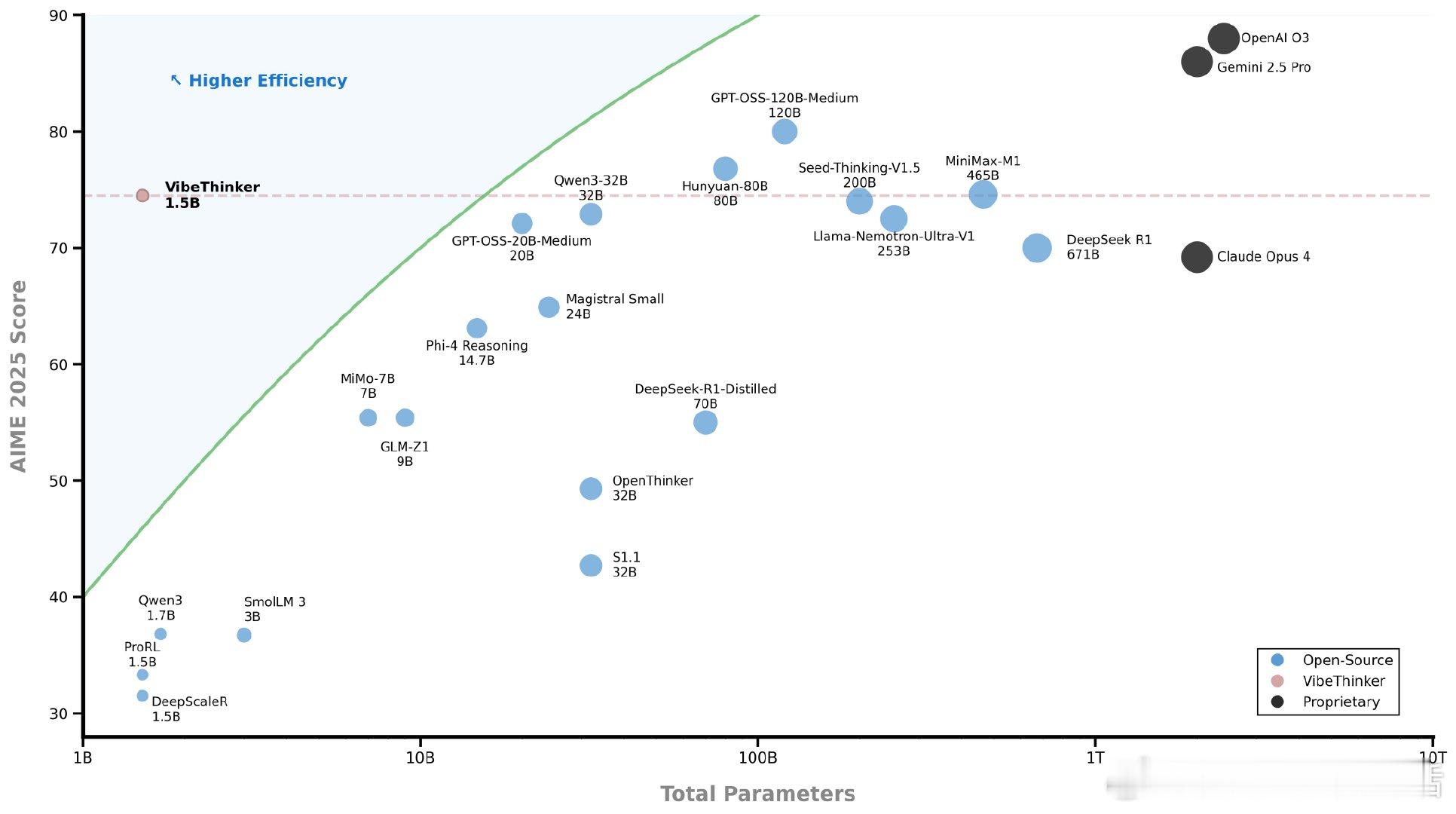

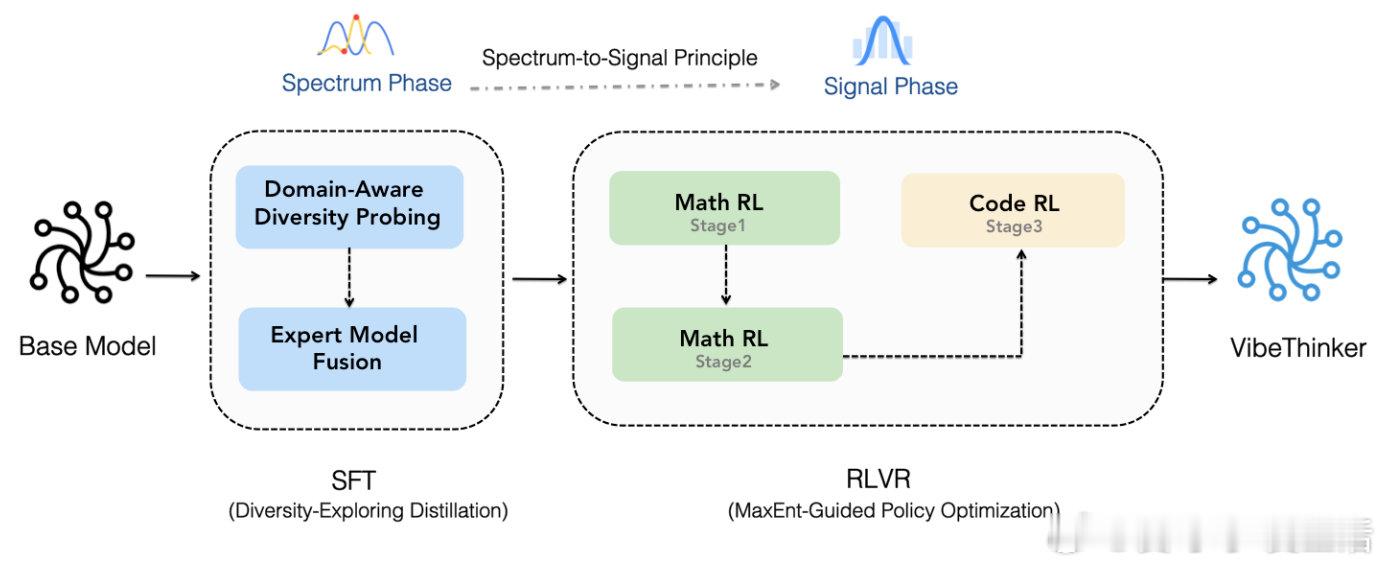

微博发布的VibeThinker-1.5B是一款拥有15亿参数的高效密集语言模型,训练成本仅7800美元,却在数学推理和代码生成任务上表现出色,性能堪比参数量远超其400倍的同类大模型。它在AIME24、AIME25和HMMT25数学竞赛基准测试中分别取得80.3、74.4和50.4的高分,超越了初代DeepSeek R1模型。代码生成能力同样突出,在LiveCodeBench v5和v6中得分领先,体现了强劲的推理能力。这一成就得益于其创新的“频谱到信号原则”(Spectrum-to-Signal Principle, SSP)训练框架:先在监督微调阶段探索解题方案多样性,再通过强化学习阶段强化正确解答信号。该方法将多样性作为核心设计理念,突破了传统训练范式,实现了极致的参数效率与推理能力的平衡。VibeThinker-1.5B适合用于竞赛风格的数学和编程问题,社区推荐的测试参数为温度0.6或1.0,最大token长度40960,top_p 0.95,top_k设为-1以优化采样效果。详细评测方案和快速上手指南已开源,支持transformers库及vLLM等推理框架。这一模型展示了“小模型也能有大逻辑”的可能性,推动了高效语言模型的研发新方向,对资源有限环境下高性能AI的普及意义重大。原文链接:huggingface.co/WeiboAI/VibeThinker-1.5B