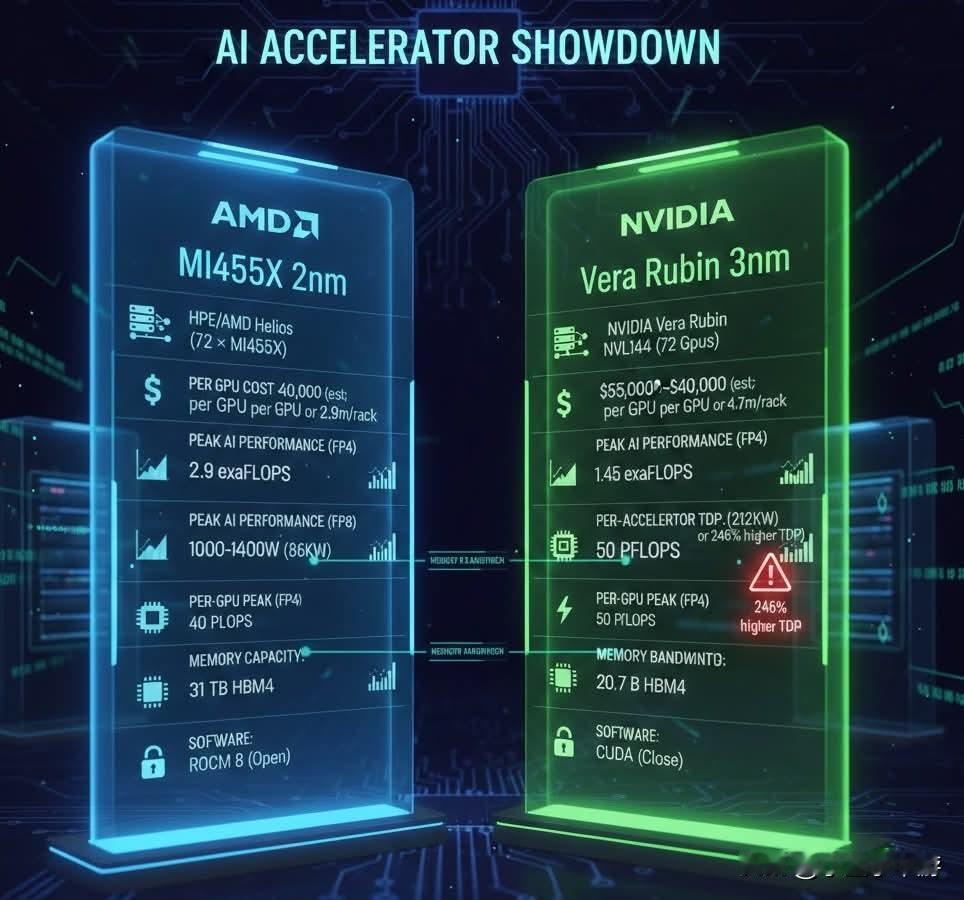

两种逻辑的巅峰较量:NVIDIA 追逐极速,AMD 押宝容量 要是仅盯着内存带宽这一单一数据,你很容易误判这场竞争的局势。今日登场的 NVIDIA Rubin 以 22TB/s 的惊人带宽,看似压制了 AMD MI455X 的 19.6TB/s,不少分析师赶忙判定 NVIDIA 再度获胜。但倘若我们深入剖析当下 AI 社群的实际应用需求,就会发现这并非简单的胜负对决。这两款芯片的规格差异,实则揭示了 AI 运算市场正经历一场关键的“战略分道扬镳”。这并非零和博弈,而是两家巨头在 AI 发展的岔路口,各自做出了截然不同的抉择。 [NVIDIA Rubin:为训练量身打造的光速跑车] NVIDIA 的选择极为明确,那便是“速度”。Rubin 采用 8 - stack HBM4 并搭配 SK Hynix 特选的高频宽颗粒,目标只有一个:缩短模型训练的时长(Time - to - Train)。 在兆级参数模型的训练集群里,数万颗 GPU 需要频繁交换数据,任何一点带宽瓶颈都会致使昂贵的算力闲置。这就是 NVIDIA 宁可牺牲单颗芯片的内存容量,也要追求极致传输速率的原因。对于像 OpenAI 或 Google 这类急于赶在对手之前发布下一代模型的客户而言,Rubin 就如同顶级赛车。他们不在意这辆车能装载多少行李,只在乎能否以最快速度冲过终点线。在“模型训练”这个分秒必争的战场,NVIDIA 通过极致的带宽规格,再次筑起了对手难以逾越的壁垒。 [AMD MI455X:吞噬模型的推理巨舰] 然而,AMD 面临的难题是:在纯粹的速度和带宽方面,他们短期内难以超越拥有供应链优先权的 NVIDIA。所以,MI455X 选择了不同的道路。它搭载的 12 - stack HBM4 设计,尽管单 pin 速率不如对手,还需承担更复杂的封装良率风险,但换来了 NVIDIA 无法比拟的优势:巨大的内存容量。 在 AI 推理(Inference)场景中,也就是 ChatGPT 回答你问题的瞬间,“装得下”往往比“跑得快”更为关键。AMD 的策略很务实,借助 12 - stack 的海量内存,单张 MI455X 足以承载更庞大的模型参数,这意味着企业能够大幅减少服务器的部署数量。如果说 Rubin 是追求极速的赛车,那 MI455X 就是一艘巨型货轮。它或许速度没那么快,但能以最低的单位成本(TCO),将 AI 服务输送到全球各地。对于微软、Meta 等需要大规模提供服务的巨头来说,这是极具吸引力的替代方案。 [各有所长的双极体系] 我们正目睹 AI 芯片市场的专业分工。过去“一款芯片通吃”的时代已然落幕。NVIDIA 继续巩固其在“模型创造”阶段的主导地位,为探索智能边界的科学家提供最强有力的工具;而 AMD 则凭借大容量内存的特性,切入了“模型服务”的广阔市场。 AMD 的 12 - stack 虽为避开 NVIDIA锋芒的无奈之举,却意外在推理市场找到了舒适的契合点。这场 Rubin 与 MI455X 的对决,最终证明市场足够大,既容得下追求极致速度的赛车手,也容得下追求极致效益的航运大亨。 这两款芯片的存在,恰恰表明 AI 产业已从早期的野蛮探索,步入了成熟的专业分工时代。

![英特尔又被AMD吊锤了?[捂脸哭]AMD正式发布Ryzen79850X3D](http://image.uczzd.cn/11377906044560150402.jpg?id=0)